好消息!科学岛团队基于视觉的多机器人全局定位方面有新进展啦!

近日,中国科学院合肥材料研究院安光电子中心计算机视觉团队开发了适合大场景多机器人协同定位的新技术。相关研究成果发表在机器人领域的国际顶级期刊上 IEEE Robotics and Automation Letters (IEEE RA-L)上。

在服务机器人领域,基于视觉同步定位和地图构建技术(SLAM)由于视觉传感器具有成本低、布局灵活、信息丰富等优点,已成为行业研究的热点。在大规模环境下,通过共享地图数据实现协同运行可以大大提高工作效率。然而,在多个机器人系统中实现不同机器人之间的整体定位(Multi-Robot Global Localization, MR-GL)它仍然面临着许多挑战。特别是在机器人初始位置未知、环境动态变化强烈的情况下,不同机器人角度差异引起的数据数据匹配困难,动态场景对算法的实时性和鲁棒性提出了更高的要求(面对内部结构或外部环境的变化)。此外,如何在确保精度的同时有效地完成多机协作定位是决定协作任务能否成功实施的关键因素之一。

针对上述问题,研究团队创新性地提出了一种结合语义和几何三重约束的图匹配多机器人的全球定位方法——SGT-MGL。该方法首先提取了场景中对象的语义和几何特征,并通过拓扑结构描述了其空间布局关系。为了增强目标的区分性,研究人员根据语义信息和相对距离构建了三角形描述符,进一步提高了特征识别度。考虑到语义和几何数据的互补特征,创新性地提出了结合语义标签、空间角和相对距离信息的三维条形图描述符,有效地提高了三角形描述符的稳定性和不变性。为了进一步减少噪声干扰,研究小组选择了“从粗到精”的匹配策略,提出了从全球几何结构中选择关键点,结合局部和全球图匹配方法,实现了多机器人之间的高精度六自由度(6-DoF)(三维位置三维方向)姿态估计。实验结果表明,该方法在提高整体定位精度方面具有显著优势。

测试数据显示,该技术在复杂动态环境中的定位精度明显高于传统方法。其突破性的三重约束机制不仅保证了算法在角度差异下的鲁棒性,而且通过分级处理具有计算效率,为未来智能医院、智能工厂等场景的多机器人协同工作提供了核心技术支持。

这项工作的第一作者是王凡博士后,通讯作者是张文副研究员和刘勇研究员。本研究得到了国家自然科学基金、合肥材料研究院院长基金和国家重点研发计划的支持。

文章链接:https://ieeexplore.ieee.org/document/10924764

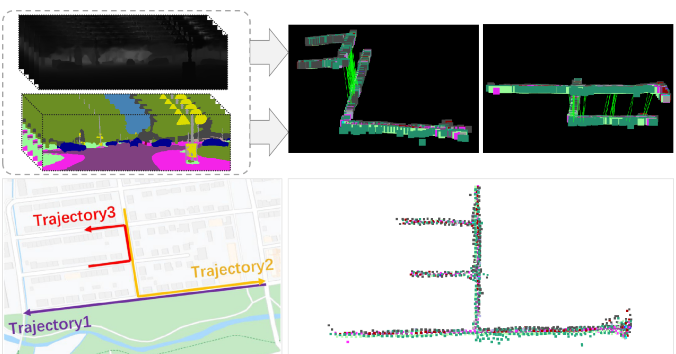

KITTI08序列数据集中多机器人全局定位方法的应用

(资料来源:合肥物质科学研究院)

赞一个

更有众多热门