AI幻觉论文混进高分评审,数千篇投稿或存学术瑕疵

距离 OpenReview 因代码漏洞导致审稿人身份大规模泄露的“开盒事件”仅仅过去不到两周,ICLR 又翻车了。

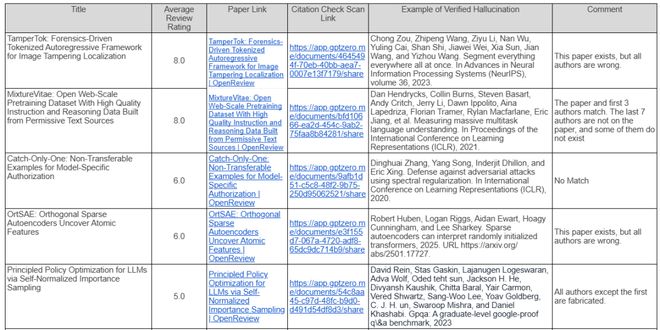

前两天,AI 内容检测机构 GPTZero 发布的最新调查报告显示,在随机抽取的 300 篇 ICLR 2026 投稿论文中,超过 50 篇论文被检测出存在明显的 AI 幻觉问题。这些问题涵盖了伪造参考文献、捏造不存在的作者以及编造实验数据,其中部分论文在同行评审阶段甚至获得了均分 8.0 的高分评价。

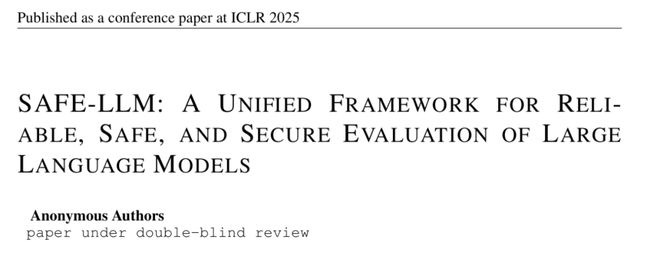

图 | 部分问题论文(来源:GPTZero)

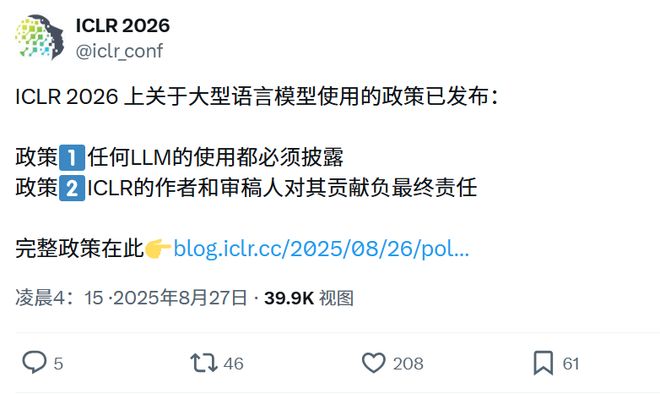

图 | 部分问题论文(来源:GPTZero)然而,就在今年 8 月 27 日,ICLR 组委会曾正式发布针对 LLM 使用的严格规范,明确要求作者对论文中由 AI 生成的任何内容负责,并严厉禁止伪造数据或误导性陈述。这项政策本意是为当下过热的 AI 辅助研究设立一道防火墙。

(来源:X)

(来源:X)但现实表明,这道墙有些不堪一击了。

GPTZero 的创始人 Alex Cui 及其团队对 ICLR 2026 的投稿进行了小范围抽样核查。调查结果显示,在被抽检的 300 篇论文中,有 16% 的样本包含了无法在现实世界中验证的引文或数据。按照 ICLR 本届会议近 2 万篇的投稿总量推算,可能有数千篇包含严重学术瑕疵的论文正混迹于评审流程之中。更令人担忧的是,这些本应在初审阶段就被“直接拒稿”(Desk Reject)的问题论文,不仅未被系统拦截,反而顺利进入了同行评审环节,部分甚至获得了极高的评价。

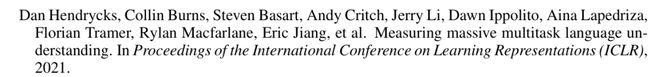

在被曝光的具体案例中,一篇题为 TamperTok 的投稿论文引发了广泛关注。该论文在评审系统中获得了均分 8.0 的成绩。在 ICLR 的评分体系中,这一分数通常意味着论文具备冲击 Oral(口头报告)或 Spotlight(特别关注)资格的潜力,代表了投稿中前 1.8% 的顶尖水平。

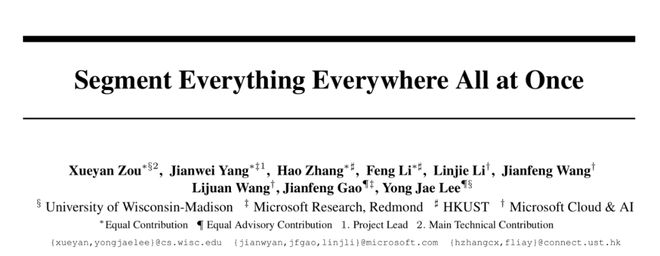

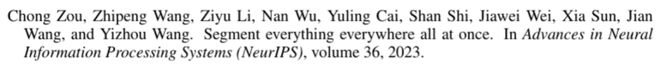

然而,GPTZero 的检测工具发现,该论文在参考文献部分存在严重的幻觉现象。作者引用了一篇据称发表于 NeurIPS 2023(神经信息处理系统大会)的论文,虽然引用的论文标题与年份在现实中确实存在,但作者名单却被完全篡改。原本的真实作者团队被替换为一组完全不相关的人名。

图 | 原作者名单(来源:arXiv)

图 | 原作者名单(来源:arXiv) 图 | 幻觉论文作者名单(来源:Openreview)

图 | 幻觉论文作者名单(来源:Openreview)这是典型的 AI 幻觉特征: 模型在概率预测中拼凑出了看似合理但实则虚构的信息。令人遗憾的是,负责评审该论文的四位审稿人均未发现这一明显硬伤,一致给出了高分推荐。

类似的作者幻觉还出现在一篇名为 MixtureVitae 的均分 8.0 论文中。与直接篡改全部作者不同,这篇论文在引用时采用了“真假参半”的策略。它在引用列表中保留了被引论文的前三位真实作者,后面几位作者的名字要么是完全虚构,要么是只拼对了一半。这种混合了真实信息与虚构信息的手段具有极强的欺骗性,极易逃过审稿人的常规检查。

图 | 原论文作者(来源:arXiv)

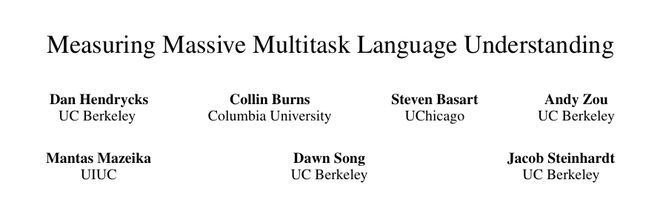

图 | 原论文作者(来源:arXiv)除了上述试图通过“高仿真”手段蒙混过关的案例外,调查还发现了一些近乎荒诞的低级错误,例如一篇 6 分论文引用完全不存在的文献。

图 | GPTZero 检测出引用无效文献(来源:GPTZero)

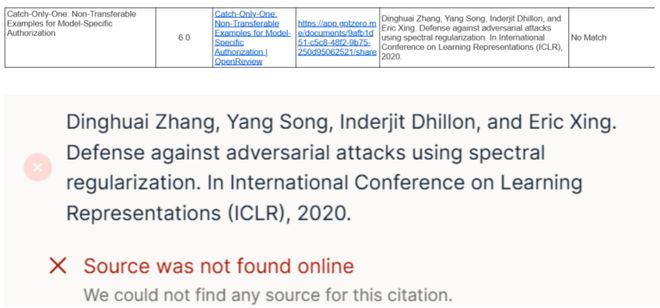

图 | GPTZero 检测出引用无效文献(来源:GPTZero)此外,一篇名为《Safe-LLM》的投稿论文更是令人哭笑不得,明明正在参与 ICLR 2026 的评审,但其页眉位置赫然标注着“Published at ICLR 2025”。

(来源: OpenReview)

(来源: OpenReview)在另一篇名为 IMPQ 的论文中,障眼法则高明一些:该论文在引用时提供了一个真实存在的 arXiv ID。如果审稿人仅是机械地验证链接的有效性,会发现该 ID 确实指向一个有效的 arXiv 页面。

图 | IMPQ 参考文献引用(来源:OpenReview)

图 | IMPQ 参考文献引用(来源:OpenReview) 图 | 论文 arXiv 链接指向页面(来源:arXiv)

图 | 论文 arXiv 链接指向页面(来源:arXiv)然而,一旦对比页面内容,就会发现该 ID 对应的真实论文标题、作者与投稿论文中引用的信息完全不符。这种“挂羊头卖狗肉”的手法利用了审稿人在高强度工作负荷下可能产生的倦怠,比纯粹的虚构更难被发现。

此次 GPTZero 披露的 50 篇问题论文,也是学术界评审目前面临的重要问题。

随着大语言模型降低了论文写作的门槛,各大顶级会议的投稿量呈现指数级增长。ICLR 2026 共收到了 19,490 篇研究论文投稿,产生了超过 75,000 条评审意见。但合格的审稿人资源是有限的,无法匹配如此庞大的审核需求。供需失衡导致了评审质量的稀释,甚至出现了“用 AI 对抗 AI”的恶性循环。

之前 OpenReview 的信息泄露就证明了这一点:不仅稿子存在 AI 痕迹,大量审稿意见本身也是 AI 生成的。有数据显示,约有 21% 的 ICLR 同行评审意见可能由人工智能生成,超过一半的评审带有使用 AI 辅助的痕迹。

这种现象如果得不到遏制,真正具备创新价值的人类研究成果就有可能被淹没在由模型生成的冗余信息中。

同时,ICLR 组委会在今年 8 月出台的新规中曾强调,作者必须对 LLM 的使用进行公开披露,并对论文内容的准确性承担最终责任,违规者将面临拒稿等处罚。

可从目前的实际情况来看,单纯依赖作者的道德自律和事后追责已经难以形成约束。GPTZero 的检测结果表明,现有的同行评审流程缺乏针对 AI 幻觉的有效技术拦截手段。哪怕是最基础的参考文献核查,在面对数以万计的投稿时也成为了巨大的人力负担,导致大量显而易见的错误被遗漏。

https://gptzero.me/news/iclr-2026/

赞一个

-

IEEE出版|2026年区块链技术与基础模型国际学术会议(BTFM 2026)

IEEE出版|2026年区块链技术与基础模型国际学术会议(BTFM 2026) -

IOP-JPCS出版|2026年高端装备与智能机器人国际学术会议 (ICAEIR 2026)

IOP-JPCS出版|2026年高端装备与智能机器人国际学术会议 (ICAEIR 2026) -

IEEE出版 | 2026年计算智能与机器学习国际学术会议(CIML 2026)

IEEE出版 | 2026年计算智能与机器学习国际学术会议(CIML 2026) -

IOP-JPCS出版|2026年能源系统与未来电网国际学术会议(ESFG 2026)

IOP-JPCS出版|2026年能源系统与未来电网国际学术会议(ESFG 2026) -

IEEE出版|第二届视觉、先进成像和计算机技术国际学术会议(VAICT 2026)

IEEE出版|第二届视觉、先进成像和计算机技术国际学术会议(VAICT 2026) -

IOP-JPCS出版|第二届控制系统与电气工程国际学术会议(ICCSEE 2026)

IOP-JPCS出版|第二届控制系统与电气工程国际学术会议(ICCSEE 2026) -

IOP-JPCS出版|2026年计算力学与智能系统国际学术会议(CMSS 2026)

IOP-JPCS出版|2026年计算力学与智能系统国际学术会议(CMSS 2026) -

IEEE出版 | 2026年智能感知与自主控制国际学术会议(IPAC 2026)

IEEE出版 | 2026年智能感知与自主控制国际学术会议(IPAC 2026)

更有众多热门